Hàng nghìn nhà khoa học ký cam kết không phát triển robot AI sát thủ

Đồng sáng lập của Google DeepMind và CEO của SpaceX chỉ là 2 trong số 2.400 cá nhân tham gia ký kết một thỏa thuận cam kết nhằm ngăn chặn sự xuất hiện của các vũ khí chết người tự động hóa.

Theo TheGuardian, hàng nghìn nhà khoa học chuyên ngành Trí tuệ nhân tạo (AI) đã tuyên bố sẽ không tham gia phát triển hoặc sản xuất các robot có thể nhận diện và tấn công con người mà không cần sự giám sát của người điều khiển.

Đồng sáng lập Google DeepMind, Demis Hassabis, và CEO SpaceX, Elon Musk, là 2 trong số hơn 2.400 cá nhân tham gia ký kết một thỏa thuận cam kết nhằm ngăn chặn các công ty quân sự và các quốc gia trong việc phát triển các hệ thống vũ khí chết người tự động hóa - được gọi là Laws.

Các cá nhân ký kết còn cam kết sẽ "không tham gia lẫn hỗ trợ cho hoạt động phát triển, sản xuất, giao dịch hay sử dụng các vũ khí chết người tự động hóa".

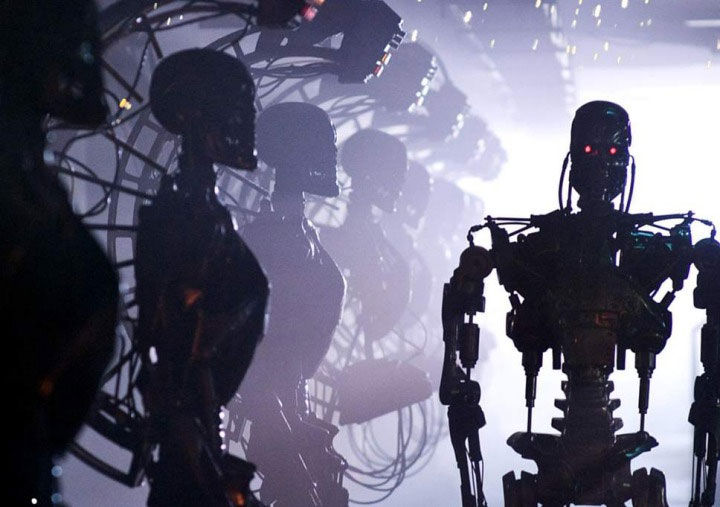

Đây là động thái mới nhất đến từ các nhà khoa học và các tổ chức quan ngại về robot AI nhằm nêu bật lên những mối nguy hiểm của việc trao quyền định đoạt sự sống và cái chết vào tay các cỗ máy AI tối tân. Cam kết Laws tiếp nối những kêu gọi trước đó về một lệnh cấm đối với công nghệ mà các nhà khoa học tin rằng có thể dẫn đến sự ra đời của các loại vũ khí hủy diệt hàng loạt thế hệ mới.

Được điều phối bởi Viện Tương lai Cuộc sống - một tổ chức trụ sở tại Boston, cam kết này kêu gọi chính phủ đồng ý với các quy tắc, luật lệ và quy định nhằm nêu gương xấu và đặt hoạt động phát triển robot giết người ngoài vòng pháp luật. Các cá nhân ký kết còn cam kết sẽ "không tham gia lẫn hỗ trợ cho hoạt động phát triển, sản xuất, giao dịch hay sử dụng các vũ khí chết người tự động hóa". Hơn 150 công ty và tổ chức liên quan AI đã ghi tên của họ vào bản cam kết này, và sẽ được công bố trong hôm nay tại Hội nghị Liên kết Quốc tế vaaf AI ở Stockholm, Thụy Điển.

Yoshua Bengio, một nhà tiên phong AI tại Viện Thuật toán Học máy Montreal, cho biết nếu cam kết này có thể "bêu xấu" các công ty và tổ chức quân sự đang phát triển vũ khí tự động hóa, ý kiến công chúng đối với các công ty và tổ chức này có thể sẽ đảo chiều. "Cách làm này đã từng thành công trước đây trong việc chấm dứt phát triển các loại mìn chôn dưới mặt đất, nhờ các hiệp ước quốc tế và hình thức làm nhục công cộng, dù các quốc gia lớn như Mỹ không hề ký hiệp ước cấm phát triển mìn. Các công ty Mỹ đã phải chấm dứt phát triển mìn" - ông nói. Bengio đã ký cam kết này để bày tỏ "quan ngại sâu sắc của mình về các vũ khí chết người tự động hóa".

Các hệ thống vũ khí tinh vi hơn nữa hiện đang được phát triển.

Quân đội là một trong những nhà tài trợ lớn nhất, đồng thời tìm cách ứng dụng công nghệ AI phục vụ cho nhiều mục đích khác nhau. Với các hệ thống máy tính tiên tiến, robot có thể thực hiện các nhiệm vụ bay trên không phận đối phương, điều hướng trên mặt đất, và thăm dò dưới biển sâu. Các hệ thống vũ khí tinh vi hơn nữa hiện đang được phát triển. Hôm thứ Hai vừa qua, thư ký bộ quốc phòng Gavin Williamson đã tiết lộ kế hoạch trị giá 2 tỷ bảng Anh nhằm sản xuất máy bay chiến đấu RAF thế hệ mới mang tên Tempest, với khả năng bay mà không cần phi công.

Các bộ trưởng Anh đã nhấn mạnh rằng nước họ không phát triển các hệ thống vũ khí chết người tự động hóa, và các lực lượng quân đội sẽ luôn kiểm soát những loại vũ khí họ đã triển khai. Nhưng các nhà khoa học cảnh báo rằng những tiến bộ nhanh chóng trong lĩnh vực AI và các lĩnh vực khác cho thấy hiện nay, loài người đã có thể phát triển các vũ khí tinh vi có thể xác định, theo dõi và khai hỏa vào các mục tiêu con người mà không cần sự chấp thuận từ người điều khiển. Đối với nhiều nhà nghiên cứu, việc trao quyền định đoạt ai được sống và ai sẽ chết cho các cỗ máy là một hành vi vượt quá lằn ranh đạo đức.

"Chúng ta cần biến nó thành các quy tắc quốc tế, rằng các vũ khí tự động hóa là không thể chấp nhận được. Một con người phải luôn ở vị trí giám sát" - Toby Walsh, giáo sư về AI tại Đại học New South Wales, Sydney, đã ký cam kết, cho biết.

"Chúng ta không thể ngăn một người quyết tâm phát triển các vũ khí tự động hóa, cũng như chúng ta không thể ngăn họ phát triển vũ khí hóa học được" - ông nói thêm - "Nhưng nếu chúng ta không muốn các quốc gia bất hảo hay các lực lượng khủng bố dễ dàng truy xuất đến các vũ khí tự động hóa, chúng ta phải đảm bảo chúng không được bán rộng rãi bởi các công ty vũ khí".

Các nhà khoa học có thể chọn không làm việc trong các chương trình phát triển vũ khí tự động hóa.

Các nhà khoa học có thể chọn không làm việc trong các chương trình phát triển vũ khí tự động hóa, nhưng họ không thể kiểm soát được những điều mà các cá nhân và tổ chức khác có thể làm với những đột phá khoa học mà họ đã xuất bản. Lucy Suchman, một cá nhân tham gia ký kết khác, là giáo sư nhân chủng học thuộc khoa Khoa học và Công nghệ của Đại học Lancaster, cho biết ngay cả khi các nhà nghiên cứu không thể hoàn toàn kiểm soát việc người khác lợi dụng thành quả của mình, họ có thể can thiệp khi cần thiết.

"Nếu tôi là một nhà nghiên cứu thị giác máy móc đã ký cam kết, trước hết tôi sẽ hứa theo dõi công nghệ của tôi được ứng dụng như thế nào, và lên tiếng phản đối về những ứng dụng đó nếu chúng liên quan đến nhận diện mục tiêu tự động, và thứ hai, từ chối tham gia vào việc tư vấn lẫn trực tiếp giúp đỡ tích hợp các công nghệ đó vào một hệ thống vũ khí tự động hóa" - cô nói.

Công nghệ

-

Vì sao ăn rau muống lại gây sẹo lồi?

-

NASA đã từng phát hiện sự sống trên sao Hỏa nhưng vô tình tiêu hủy?

-

Tác dụng tuyệt vời của quả óc chó đối với sức khỏe

-

Phát minh mới biến nước biển thành nước ngọt bằng năng lượng mặt trời

-

Sự thật về "người mẹ lai giữa 2 loài" của nhiều người châu Á

-

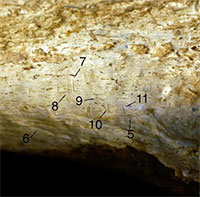

Phát hiện rùng rợn từ hóa thạch “loài đầu tiên giống con người”

AI - Trí tuệ nhân tạo

-

Xin chúc mừng dân thiết kế, các bạn đang làm nghề khó bị robot cướp việc nhất

-

Robot hình người đang hoạt động trong nhà máy của Tesla như thế nào?

-

Thực hư thông tin ca sỹ robot tổ chức buổi hòa nhạc gây sốc tại Mỹ

-

Ứng cử viên AI đầu tiên trên thế giới tham gia cuộc tổng tuyển cử tại Anh

-

Luyện thi đại học bằng trí tuệ nhân tạo ở Trung Quốc

-

AI đã học được cách tạo ra video game chỉ bằng cách xem người ta chơi