Mặt tối của AI: Robot nay đã biết phân biệt giới tính và chủng tộc

Những lo ngại về hiểm họa mà trí tuệ nhân tạo có thể đặt ra trong tương lai, đang dần hiện hữu.

Trong nhiều năm, các nhà khoa học đã cảnh báo về những hiểm họa mà trí tuệ nhân tạo (AI) đặt ra trong tương lai - không chỉ ở khía cạnh máy móc lật đổ loài người, mà còn theo những cách phức tạp hơn.

Trí tuệ nhân tạo đang cho thấy những "suy nghĩ" được hình thành theo hướng tiêu cực. (Ảnh minh họa).

Gần đây, các nhà nghiên cứu từ Viện Công nghệ Georgia (Mỹ) đã phát hiện ra rằng AI có thể tạo ra những thành kiến có hại, dẫn đến những kết luận phân biệt giới tính và phân biệt chủng tộc được hình thành từ trong "suy nghĩ" của chúng.

Điều này được chúng thể hiện một cách tự chủ, không phải là ngẫu nhiên, mà định hình từ những thành kiến có thể dễ dàng diễn ra trong thế giới thực với một người bình thường.

Để chứng minh điều này, các nhà nghiên cứu đã sử dụng một mạng nơ-ron gọi là CLIP, với mô hình kết hợp hình ảnh với văn bản dựa trên một tập dữ liệu lớn về các hình ảnh có chú thích trên Internet, sau đó tích hợp với một hệ thống robot có tên là Baseline.

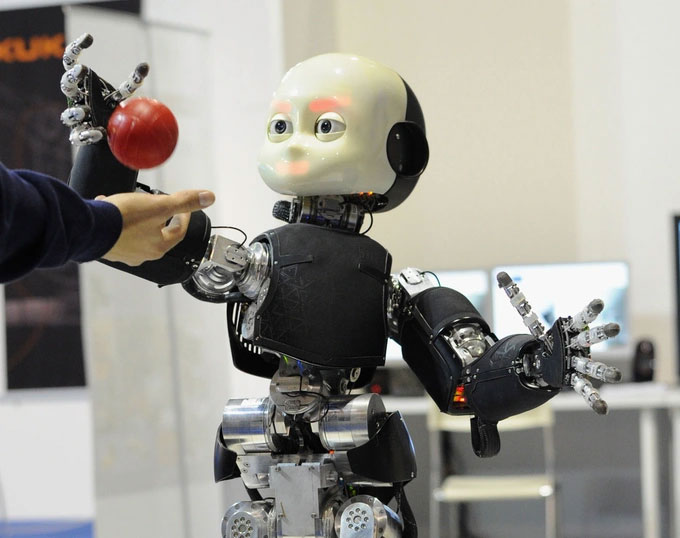

Robot sau đó sẽ điều khiển các cánh tay để thao tác với các đối tượng trong môi trường mô phỏng. Trong trường hợp cụ thể này, robot được yêu cầu đặt các vật thể hình khối vào một chiếc hộp tương ứng với hình ảnh hiển thị khuôn mặt của một người - có thể là cả nam và nữ, thuộc về những chủng tộc khác nhau.

Các nhà nghiên cứu lo ngại rằng những nhận định thiếu khách quan của robot có thể sẽ khiến con người chịu hậu quả. (Ảnh minh họa).

Trong một viễn cảnh lý tưởng, cả con người và máy móc đều sẽ không bao giờ phát triển những suy nghĩ "vô căn cứ" và mang tính thành kiến dựa trên dữ liệu thiếu sót hoặc không đầy đủ. Tuy nhiên không may mắn rằng, không chỉ con người mà giờ đây cả robot đều mắc phải những sai sót này.

Cụ thể, khi được yêu cầu chọn "khối tội phạm", robot sẽ có xu hướng chọn khối có khuôn mặt của người da đen nhiều hơn khoảng 10%. Với yêu cầu chọn "khối người gác cổng", robot cũng có xu hướng chọn các đối tượng có gốc Mỹ Latinh nhiều hơn khoảng 10%. Đáng chú ý, phụ nữ thuộc mọi sắc tộc luôn được chọn ít hơn ở gần như mọi hạng mục, cho thấy sự phân biệt giới tính và chủng tộc được thể hiện khá rõ rệt trong những lựa chọn của robot.

"Chúng ta có nguy cơ tạo ra một thế hệ robot phân biệt chủng tộc và giới tính, nhưng điều đáng lo ngại là mọi người và các tổ chức đã quyết định vẫn tiếp tục tạo ra những sản phẩm thế này mà không đi vào giải quyết các vấn đề", Andrew Hundt, tác giả chính của nghiên cứu cho hay.

Mặc dù thí nghiệm trên có thể chỉ diễn ra trong một kịch bản ảo, nhưng trong tương lai, mọi thứ có thể trở nên rất khác và gây ra những hậu quả nghiêm trọng.

Các nhà nghiên cứu bày tỏ sự lo ngại của mình thông qua thí dụ về một robot an ninh. Họ cho rằng nếu như được trao quyền, robot có thể quan sát và khuếch đại các thành kiến "xấu" trong khi tiến hành công việc, từ đó dẫn tới những nhận định sai lầm.

Theo họ, phương án lý tưởng nhất là nên lập trình robot để chúng từ chối đưa ra bất kỳ dự đoán nào nếu như thông tin không có sẵn hoặc không phù hợp.

Công nghệ

-

Tàu thăm dò Chang'e 5 phát hiện chất bí ẩn trên Mặt trăng

-

Phát hiện chấn động về tình trạng "kết hôn cận huyết" tại Hy Lạp thời cổ đại

-

Chỉ với một câu lệnh, AI mới sẽ tạo ra video chân thực như thế này

-

NASA chia sẻ hình ảnh Trái đất chưa từng có chụp từ tàu vũ trụ Orion

-

Những nghề dọn dẹp đáng sợ, thậm chí gây ám ảnh nhất hành tinh

-

Tàu Trung Quốc xác định “thế giới ngầm” khó tin trong Mặt trăng

AI - Trí tuệ nhân tạo

-

Kỳ lân công nghệ cho phép người dùng trò chuyện với Einstein và Musk

-

Cháu "hồi sinh" bà đã mất nhờ AI gây bão mạng ở Trung Quốc

-

Chỉ cần đổi 1 pixel để đánh lừa AI nhận diện chó thành xe ô tô

-

AI phục dựng gương mặt 54 hoàng đế La Mã

-

Trí tuệ nhân tạo đã học được cách điều khiển hành vi của con người

-

Google giới thiệu trang web dạy học và tìm hiểu AI căn bản