Sẽ ra sao nếu AI trở thành hacker?

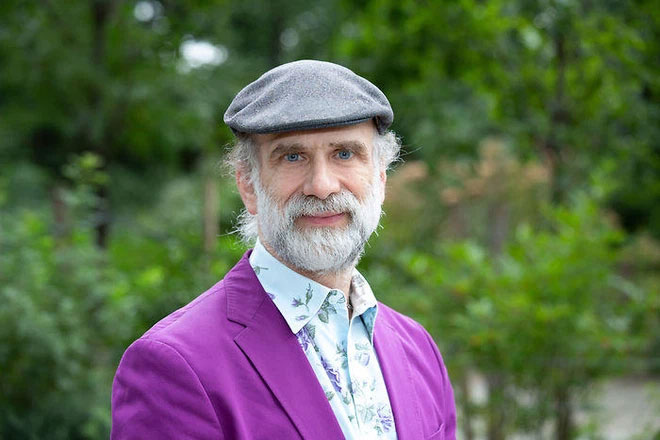

Trong vài năm qua, chuyên gia công nghệ và nhà nghiên cứu Bruce Schneier đã tìm hiểu về khả năng bị hack của các hệ thống xã hội, cụ thể là các thị trường tài chính, pháp luật, và mã số thuế. Và đó là lúc ông nghĩ đến những hệ quả tiềm tàng của trí tuệ nhân tạo đối với xã hội chúng ta: liệu bản thân các hệ thống AI có thể tiến hoá đến mức vô tình - và tự động - gây tổn hại cho các hệ thống xã hội hay không?

"Đó là lúc AI trở thành hacker, thay vì hacker hack các hệ thống AI" - ông nói

Schneier sẽ thảo luận về nghiên cứu của mình vào thứ hai tới đây tại Hội thảo RSA 2021, được tổ chức trực tuyến. Chủ đề AI được dựa trên một bài luận mới đây do Bruce viết cho Dự án sử dụng AI có trách nhiệm tại Trung tâm Khoa học và Quan hệ Quốc tế Belfer tại Trường Kennedy của Harvard.

Câu hỏi cốt lõi mà Schneier đưa ra là: sẽ ra sao nếu các hệ thống AI có thể hack các hệ thống xã hội, kinh tế và chính trị trên quy mô, tốc độ, và phạm vi máy tính mà con người không thể kịp thời phát hiện rồi lãnh mọi hậu quả?

Đó là khi AI bước vào một "quy trình sáng tạo nhằm tìm kiếm các vụ hack".

"Chúng đã và đang làm điều đó trong lĩnh vực phần mềm, tìm kiếm những lỗ hổng trong mã máy tính. Chúng làm việc đó không tốt lắm, nhưng dần dần sẽ tốt hơn trong khi con người vẫn dậm chân tại chỗ" về khả năng phát hiện lỗ hổng - Schneier nói.

Ông dự báo rằng trong chưa đầy một thập kỷ nữa, AI sẽ có thể "đánh bại" con người trong các cuộc thi hack kiểu "cướp cờ", bằng chứng là trong cuộc thi DEFCON năm 2016, một đội thi tên Mayhem chỉ gồm toàn các AI đã vượt qua mọi đội thi con người để vào trận chung kết. Đó là bởi công nghệ AI chắc chắn sẽ tiến hoá và vượt quá khả năng của con người.

Schneier nói rằng mối lo của ông không hẳn là AI "đột nhập" vào các hệ thống, mà là AI tạo ra các giải pháp của riêng mình. "AI tìm ra một lỗ hổng và một giải pháp can thiệp, và con người sẽ dùng nó như một cách để kiếm tiền, như các quỹ mạo hiểm trong lĩnh vực tài chính".

Điều trớ trêu ở đây là AI hình thành nhờ lập trình của con người, nhưng chúng không có chức năng nhận thức như con người, ví dụ sự đồng cảm hay ý chí để biết khi nào cần làm gì. Schneier nhấn mạnh rằng dù đã có nhiều nghiên cứu nhằm trang bị khả năng nhận thức bối cảnh, đạo đức, và giá trị vào các chương trình AI, các hệ thống AI ngày nay đơn giản là không có chức năng đó.

Ngay cả vậy, con người cũng sẽ tận dụng được AI để tìm các lỗ hổng trong mã số thuế, như một công ty kế toán lớn vẫn thường làm để tìm một "con đường tránh thuế mới nhằm bán cho khách hàng". Do đó, các công ty tài chính nhiều khả năng sẽ không muốn lập trình thêm các quy tắc gây ảnh hưởng đến khả năng kiếm tiền từ AI của họ.

Nguy cơ lớn nhất ở đây là AI sẽ tìm được cách để lách luật mà con người không biết được - "AI sẽ tìm ra một số cách để can thiệp vào các quy định và chúng ta sẽ không nhận ra điều đó" - Schneier nói.

Schneier lấy ví dụ về vụ scandal của Volkswagen năm 2015, khi nhà sản xuất xe hơi này bị phát hiện gian lận trong các bài kiểm tra mức độ khí thải của các mẫu phương tiện của mình sau khi các kỹ sư lập trình hệ thống máy tính của xe nhằm kích hoạt chức năng hạn chế khí thải trong quá trình kiểm tra chứ không phải trong hoạt động bình thường.

Ông nói rằng "đó là con người phá luật", không phải AI, nhưng là một ví dụ cho thấy AI có thể gian lận trong một hệ thống nếu được "thả" cho tự học hỏi bên trong hệ thống đó.

Trong bài luận của mình, "Sự trỗi dậy của các hacker AI", Schneier miêu tả như sau: "Nếu tôi yêu cầu bạn thiết kế một phần mềm kiểm soát động cơ xe hơi để tối đa hiệu suất trong khi vẫn vượt qua các bài test về kiểm soát khí thải, bạn sẽ không thiết kế được phần mềm có khả năng gian lận mà không tự nhận thức được mình đang gian lận. Điều này đơn giản là không đúng đối với một AI; nó không hiểu khái niệm trừu tượng như gian lận. Nó sẽ có suy nghĩ ngoài khuôn khổ đơn giản bởi nó không có khái niệm về khuôn khổ, hoặc về những giới hạn trong các giải pháp hiện có của con người. Hoặc về đạo đức. Nó sẽ không hiểu rằng giải pháp của Volkswagen sẽ gây hại cho người khác, rằng nó đang bóp méo ý nghĩa của bài test khí thải, hoặc nó đang phá luật".

Nhà nghiên cứu Bruce Schneier.

Hồi chuông cảnh tỉnh

Schneier thừa nhận khái niệm AI như một hacker là "rất hoang đường" ở thời điểm hiện tại, nhưng nó lại là một vấn đề cần được giải quyết.

"Chúng ta cần suy nghĩ về điều này" - ông nói. "Và tôi không chắc bạn có thể ngừng điều đó lại được. Khả năng xuất hiện tình trạng AI là hacker tuỳ thuộc nhiều vào câu hỏi: làm cách nào chúng ta đưa các quy định của hệ thống vào mã lệnh?"

Mấu chốt ở đây là tận dụng sức mạnh của AI vào hoạt động phòng thủ, như tìm kiếm và khắc phục mọi lỗ hổng trong một phần mềm trước khi nó được tung ra.

"Lúc đó chúng ta sẽ sống trong một thế giới nơi các lỗ hổng phần mềm là chuyện của quá khứ" - ông nói.

Mặt trái là thời kỳ chuyển dịch sẽ rất khó khăn: những mã lệnh lỗi thời hoặc đã được tung ra trước đó có thể đứng trước nguy cơ bị tấn công bởi các công cụ AI do kẻ xấu điều khiển.

Nguy cơ đó chính là các hệ thống AI tấn công các hệ thống AI khác trong tương lai, và con người sẽ sụp đổ, ông nói.

Nghiên cứu AI mới nhất của Schneier là sự tiếp nối của nghiên cứu của chính ông về cách ứng dụng tư duy và kỹ năng hacker để bảo vệ các hệ thống xã hội từng được trình bài tại Hội thảo RSA 2020 ở San Francisco. Khái niệm mà ông gọi là "hack xã hội" có nghĩa là các hacker có đạo đức sẽ giúp khắc phục những lỗ hổng - ví dụ trong mã số thuế và luật pháp của Mỹ để tránh những mối nguy hiểm phát sinh do vô tình hoặc cố ý.

Ý tưởng lớn của Schneier tựu chung lại ở một câu hỏi: "Chúng ta có thể hack xã hội và góp phần bảo vệ an toàn cho các hệ thống cấu thành xã hội hay không?"

Đồng thời, đừng quên để mắt đến việc AI tham gia vào hack xã hội.

"Máy tính nhanh hơn con người nhiều. Một quy trình do con người xử lý có thể mất vài tháng hoặc vài năm, nhưng chỉ còn vài ngày, vài giờ, hay thậm chí vài giây. Điều gì sẽ xảy ra khi bạn trao cho AI toàn bộ mã số thuế Mỹ và ra lệnh cho nó tìm ra mọi cách để có thể tối thiểu hoá tiền thuế còn nợ?" - ông viết trong bài luận.

Công nghệ

-

Cảnh tượng tàn khốc ở Tây Ban Nha sau trận lũ quét dữ dội, chính phủ tuyên bố 3 ngày Quốc tang

-

Côn trùng giúp tìm manh mối thợ săn trộm tê giác như thế nào?

-

Từ bên ngoài Hệ Mặt trời, tàu Voyager 1 vẫn gửi dữ liệu về Trái đất

-

"Đạn đại bác" khủng khiếp nhất lao vụt qua kính viễn vọng NASA

-

Hòn đảo năng lượng nhân tạo đầu tiên trên thế giới

-

Phát hiện loài vật có "tửu lượng" mạnh nhất thế giới

AI - Trí tuệ nhân tạo

-

Lần đầu tiên trong lịch sử IBM chế tạo thành công neuron nhân tạo

-

Các chuyên gia tranh cãi về AI có nhận thức

-

AI của Google sẽ cứu lợn biển trước nguy cơ tuyệt chủng

-

Trí thông minh nhân tạo có thể thi đậu tại phần lớn đại học ở Nhật

-

Facebook "khai tử" một hệ thống AI tự phát triển ngôn ngữ riêng

-

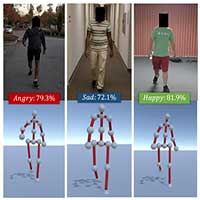

AI mới này có thể đoán cảm giác của con người thông qua dáng đi