Trí tuệ nhân tạo của Google có thêm kỹ năng học nhanh

Kĩ thuật mới được tìm ra có thể giúp trí tuệ nhân tạo đạt tới 87% hiệu suất của những tay chơi kiệt xuất trong trò chơi.

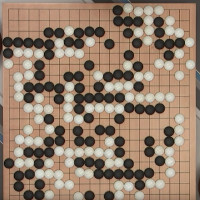

Theo Engadget, Khi nói đến trí tuệ nhân tạo (AI), giá trị của mỗi thành quả đạt được đều đáng nhớ. Điều đó đặc biệt đúng với DeepMind của Google đã chứng minh bản thân bằng cách đánh bại nhà vô địch cờ vây thế giới Lee Sedol, bắt chước giọng nói con người và giảm hóa đơn điện cho máy chủ.

Từ DeepMind

Hiện tại, một nhóm nghiên cứu đã công bố phương pháp "học tăng cường" mới trên nền tảng AI để tăng tốc độ tự đào tạo chính mình mà không cần sự giảng dạy trực tiếp của con người.

Trước hết, DeepMind đã nắm bắt tốt hơn việc kiểm soát các điểm ảnh trên màn hình. Google đã chú thích điều đó "tương tự như cách một đứa trẻ học cách kiểm soát tay của mình bằng cách di chuyển chúng và quan sát sự chuyển động". Bằng cách này, đứa trẻ có thể tìm ra cách tốt nhất để có được điểm số cao và tham gia các trò chơi hiệu quả hơn.

DeepMind đã nắm bắt tốt hơn việc kiểm soát các điểm ảnh trên màn hình.

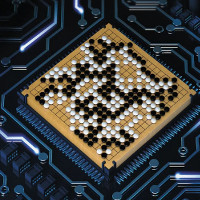

...đến UNREAL

Ngoài ra, hiện tại DeepMind còn có thể tìm ra các phần thưởng từ một trò chơi dựa trên những lần thực hành trong quá khứ. "Bằng cách ôn lại lịch sử về các phần thưởng thường xuyên hơn, DeepMind có thể khám phá các tính năng tiên đoán mang tính trực quan nhanh hơn nhiều lần", Google cho biết. Trong một bài báo, công ty gọi khái niệm về toàn bộ những khả năng của AI với tiêu đề Tăng cường khả năng học tập bằng những nhiệm vụ phụ trợ không cần giám sát - Reinforcement Learning with Unsupervised Auxiliary Tasks.

Những kỹ năng này, cùng với các phương pháp học sâu tăng cường trước đó của DeepMind- đã tạo nên UNREAL (UNsupervised REinforcement and Auxiliary Learning). Đó chỉ là phần nhỏ, thành quả lớn nhất là DeepMind đang bắt đầu "dạy cho bản thân giống như con người". Nhóm nghiên cứu mô tả các phương pháp DeepMind sử dụng tương tự như cách động vật mơ về các sự kiện tích cực và tiêu cực (mặc dù họ không thực sự biết DeepMind đã học cách làm thế nào để "mơ").

Trong một môi trường mê cung 3D gọi là Labryinth, Google cho biết UNREAL vẫn có thể học các giai đoạn nhanh hơn khoảng 10 lần. Nó có thể đạt được 87% hiệu suất của một người chơi kiệt xuất trong trò chơi, và khoảng 9 lần so với người chơi thông thường trong một loạt các tựa game Atari.

Nhìn chung, UNREAL đã giúp DeepMind đáng kể. Nhưng nhóm nghiên cứu sẽ phải đợi xem liệu những thành quả đạt được có thể hữu dụng trong các tình huống bên ngoài trò chơi hay không?

- Trí tuệ nhân tạo

- Trí tuệ nhân tạo viết chữ giống y như con người

- Trí tuệ nhân tạo, deep learning, machine learning là gì?

- Liệu trí tuệ nhân tạo phát triển có đặt dấu chấm hết cho chủng tộc loài người?

- Trí tuệ nhân tạo chẩn đoán ung thư vú nhanh hơn bác sĩ 30 lần

- Dạy trí tuệ nhân tạo Hóa học để nó có thể tìm ra loại thuốc mới

- Trí tuệ nhân tạo gây nên những cơn ác mộng cho con người

Công nghệ

-

Những nghề dọn dẹp đáng sợ, thậm chí gây ám ảnh nhất hành tinh

-

Vật liệu có thể soán ngôi kim cương về độ cứng

-

Lưu ý khi sử dụng lò vi sóng bạn nên biết

-

Phát hiện chấn động về tình trạng "kết hôn cận huyết" tại Hy Lạp thời cổ đại

-

NASA chia sẻ hình ảnh Trái đất chưa từng có chụp từ tàu vũ trụ Orion

-

Video: Đoạn phim hoạt hình "Tây du ký" dựng từ AI làm khán giả kinh ngạc

AI - Trí tuệ nhân tạo

-

Trung Quốc phát triển robot hình người biểu cảm chân thực

-

AI vẫn bị con người bỏ xa về khả năng dự báo thời tiết

-

Chân dung nhà thơ nổi tiếng được phục chế bằng AI

-

ChatGPT và các ứng dụng AI đang lấy đi việc làm của chúng ta?

-

Trí tuệ nhân tạo: Hóa giải thách thức lớn nhất trong nghiên cứu sinh học

-

NVIDIA huấn luyện robot có khả năng học hỏi thông qua quan sát con người