Giao tiếp với máy móc: Chuyện không còn xa vời

Một câu chuyện về cách mà các nhà khoa học đang tạo ra những chiếc máy tính biết nói, không chỉ vậy mà đó là những âm thanh giống con người và tự nhiên nhất mà chúng ta từng được nghe phát ra từ máy móc.

Phòng thu âm GM Voices nằm ẩn mình trên con đường ở Alpharetta, Georgia, một vùng ngoại ô trù phú ở Atlanta. Nó có nhiệm vụ thu âm cho những video hướng dẫn của công ty, thu những lời nhắc nhở cho hệ thống thư thoại/thông báo điện tử, và những thứ tương tự – nghe không hấp dẫn lắm, nhưng đối với những diễn viên lồng tiếng, nó là một công việc ổn định. September Day là một trong những diễn viên đó, và vào một buổi sáng của năm 2011, cô đến đây để bắt đầu làm việc cho một dự án đặc biệt.

Công nghệ nhận diện giọng nói đang được áp dụng trong một số mẫu xe hơi cao cấp

Day là một bà mẹ 37 tuổi, đã từng làm việc cho rất nhiều khách hàng nổi tiếng – những công ty như MTV, Dominos Pizza, và Nickelodeon – cô cũng đã được thông báo một số chi tiết về công việc. Cô biết mình được thuê để làm một dự án "chuyển đổi văn bản thành giọng nói" (text to speech – TTS) – một dự án nhằm giúp cho máy tính có thể đọc văn bản thành tiếng như con người.

Day tự tin đến làm việc dù mới sinh con 4 ngày trước, cô không hề được chuẩn bị cho những gì sắp xảy đến với mình.

Ivona – một công ty Ba Lan chuyên về lĩnh vực TTS – đã tạo ra một giọng nói điện tử có thể được tích hợp vào Kindle Fire, một phiên bản mini của chiếc máy tính bảng nổi tiếng của Amazon. Khi người dùng Kindle Fire nhấn vào một thiết lập nào đó, họ có thể được nghe "Salli" đọc sách cho mình.

Trong vòng 8 ngày, mỗi ngày từ 6 đến 7 tiếng, Day có nhiệm vụ đọc những tài liệu như truyện "Alice đến xứ sở thần tiên", một vài mẩu tin của hãng AP, và đôi khi là một vài câu nói bất kỳ, trong khi phải ngồi yên tại chỗ. Cô phải đọc hàng trăm con số, với những ngữ điệu khác nhau: "Một! Một. Một? Hai! Hai. Hai?".

"Tôi giống như Người Sắt (Ironman) vậy!" – Day chia sẻ – "Tôi chưa hề có kinh nghiệm với bất kỳ việc gì như thế này! Tôi từng là nữ hoàng của những chương trình TV 30-60 giây. Đó là chỗ dành cho tôi". Đến ngày thứ tư Day đã phải xin nghỉ, bởi vì cổ họng cô đã khản đặc. Nhưng sau đó Day đã lấy lại can đảm, và trở lại lồng tiếng cho rất nhiều tài liệu.

Những câu chuyện như của Day đang ngày càng phổ biến, khi mà những thiết bị biết nói đang xuất hiện ngày càng nhiều. Không còn là một cái gì đó mới lạ, những ứng dụng như Siri, hệ thống GPS, và các ứng dụng chuyển đổi văn bản thành giọng nói đang trên đà phát triển. Có thể dễ dàng nhận thấy sự cần thiết của chúng: Khi đang lái xe bạn không thể tra Google bằng tay, vì vậy bạn phải yêu cầu điện thoại tìm cho mình một cửa hàng Starbucks.

Bạn đang ở phòng tập và có phần mềm RSS reader đọc cho mình những bản tin tài chính mới nhất. Google, Apple, Microsoft hay thậm chí cả Amazon đều đã đầu tư mạnh tay vào lĩnh vực này, và rất nhiều người tin rằng chúng ta mới đang thấy sự khởi đầu của những cuộc trò chuyện với máy móc (theo đúng nghĩa đen).

Hiện giờ, các ứng dụng phát âm từ điện thoại và ô tô có giọng nói giống như con người. Đó là bởi đó là từ con người, hoặc ít ra từng là của con người.

Với mỗi đoạn hội thoại của Siri lại cần có một diễn viên ngồi trong một phòng thu để thu âm. Một khi người đó hoàn thành xong công việc của mình, họ có thể ra về. Nhưng bản thu của họ mới chỉ bắt đầu cuộc hành trình của mình. Đó là một chuỗi các quy trình công nghệ mà mười năm trước còn bất khả thi. Nhưng nó cũng đồng thời là câu chuyện về lòng khát khao cố hữu muốn được có những mối quan hệ của mỗi người chúng ta, kể cả với những vật vô tri vô giác.

J. Brant Ward là giám đốc của bộ phận phát triển và thiết kế giọng nói ở Nuance. Ông đã làm việc ở thung lũng Silicon hơn một thập kỷ, từng viết những bản hòa tấu cho các nhạc cụ synthesizer hay những bài phát biểu sử dụng giọng nói tổng hợp.

Nuance là một trong những công ty chuyên về nhận diện và chuyển đổi văn bản thành giọng nói lớn nhất thế giới. (Nhận diện giọng nói có vẻ ngược lại với chuyển đổi văn bản thành giọng nói – máy tính sẽ chuyển lời nói của bạn thành văn bản). Họ làm nhiều việc như cung ứng những chiếc máy ghi dữ liệu bằng giọng nói cho ngành y tế. Họ cũng đưa công nghệ nhận diện và chuyển đổi văn bản thành giọng nói vào mọi thứ từ máy tính bảng cho tới ô tô.

Ward và trưởng nhóm thiết kế của công ty – David Vazquez – là những thành viên của một nhóm làm việc tại văn phòng ở Sunnyvale, CA, Mỹ có nhiệm vụ tạo ra một thế hệ giọng nói tổng hợp mới. Họ miêu tả công việc của mình là: "sự kết hợp giữa nghệ thuật và khoa học".

Ngành công nghiệp chuyển đổi văn bản thành giọng nói có tính cạnh tranh và tính bảo mật rất cao. Mặc dù ai cũng biết rằng Nuance đã tạo ra giọng nói của Siri, Ward và Vazquez lại lảng tránh khi được hỏi về vấn đề này.

Vậy làm thế nào để họ tạo nên giọng nói đó? Không cần phải nói ra ai cũng hiểu họ không làm bằng cách ghi âm từng từ trong từ điển. Nhưng khi bạn nghĩ tới một ứng dụng có thể đọc to bất kỳ thông báo mới nào hiện lên trên new feed, hoặc tìm kiếm trên trang web cho bạn, nó cần phải nói được mọi từ trong từ điển.

"Hãy hỏi bạn muốn biết địa chỉ của cửa hàng hoa gần nhất" – Ward nói – "Có tới 27 triệu cửa hàng trên toàn nước Mỹ. Chúng tôi không thể ghi âm tên của từng cửa hàng một".

"Đó là lúc phải tìm ra đường tắt" – Vazquez nói, đồng thời lôi ra một tờ văn bản. Nó giống như kịch bản của vở Hamlet, nhưng được đánh máy theo lối Excel với những câu kỳ lạ như: Scratching the collar of my neck, where humans once had gills.

Hầu hết các câu đã được lựa chọn, theo Vazquez, bởi chúng "giàu ngữ âm: nghĩa là chúng là sự kết hợp của rất nhiều đơn âm khác nhau. Những câu này giống như những câu có thể làm líu lưỡi người nói".

"Vấn đề là, càng có nhiều dữ liệu thì chúng tôi càng có thể làm cho giọng nói trở nên sống động" – Ward nói. Những câu văn này, mặc dù vô nghĩa, nhưng lại ẩn chứa rất nhiều thông tin.

Sau khi văn bản được thu âm với giọng của một diễn viên, một quá trình xử lý bắt đầu. Nó có thể kéo dài hàng tháng trời. Những từ ngữ và câu văn được đem ra phân tích, xếp loại và đính kèm với một cơ sở dữ liệu, một công việc phức tạp đòi hỏi một đội ngũ các nhà ngôn ngữ học cũng như các phần mềm chuyên biệt.

Khi quá trình được hoàn tất, phần mềm chuyển đổi văn bản thành giọng nói của Nuance có thể tìm đúng những từ được ghi âm và kết hợp chúng lại để tạo ra những từ và cụm từ mà người diễn viên có lẽ chưa hề thốt ra, nhưng lại nghe rất giống như người diễn viên đó đang nói chuyện, bởi vì về mặt kỹ thuật đó chính là giọng của người diễn viên đó.

Cái tên chính thức cho quá trình đó là "lựa chọn đơn vị" hay "tổng hợp giọng nói". Ward miêu tả quá trình này giống như "viết một bức thư đòi tiền chuộc": các chữ được cắt ra và ghép với nhau thành câu – một sự đơn giản hóa triệt để của quá trình chúng ta tạo ra ngôn ngữ.

Là con người, chúng ta được học nói trước khi học viết. Nói là một hành động vô thức: Chúng ta thực hiện hành động đó mà không hề nghĩ đến việc mình đang thực hiện nó, và chắc chắn chúng ta không nghĩ về những sự dao động của âm điệu, độ cao, tốc độ, sự liên kết giữa các âm và những nhân tố khác cho phép chúng ta truyền tải một cách liên tục và hiệu quả những ý tưởng và cảm xúc phức tạp. Nhưng để một chiếc máy tính có thể làm được như vậy thì tất cả các yếu tố đó đều phải được tính đến, một công việc được một giáo sư ngôn ngữ miêu tả là "khó hơn lên giời".

Hãy lấy ví dụ về âm "A" trong từ "cat". Nó sẽ được phát âm với một chút khác biệt khi đặt trong từ "catty" hay "alligator".

Cấu trúc câu lại tiềm ẩn nhiều thách thức khác. "Nếu như bạn nói: "Quý khách đi San Francisco hay New York", độ cao của âm sẽ tăng lên ở cuối câu" – Vazquez nói. Nhưng nếu như đó là một câu hỏi với nhiều lựa chọn, như: "San Francisco, Philly hay New York?" thì âm "York" sẽ phải hạ thấp xuống. Không xử lý được những vấn đề đó sẽ khiến cho người dùng cảm thấy không tự nhiên.

Bạn không nên nghĩ rằng mình đang nói chuyện với một cái máy. Bạn không nên suy nghĩ gì cả!

"Lũ trẻ nhà tôi giao tiếp với Siri như thể đó là một vật thể sống" – Ward nói – "Chúng yêu cầu nó tìm kiếm mọi thứ cho mình. Chúng không hề nhận thấy sự khác biệt".

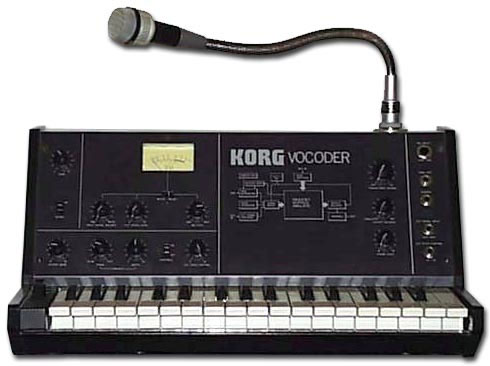

Nỗ lực tạo ra tiếng nói nhân tạo đã có từ thế kỷ 18, khi những nhà khoa học tiến hành những thí nghiệm nhằm thu được những nguyên âm. Nhưng thành tựu tốt nhất thời đó là chiếc máy Vocoder - một chiếc máy được phát minh bởi Bell Labs vào năm 1928 có tác dụng truyền âm, dưới dạng tín hiệu mã hóa, tới các đồng minh trong Thế chiến II. Chiếc máy Vocoder đã trở thành nguồn cảm hứng cho chiếc máy tính biết nói Hal 9000 của nhà văn Arthur C. Clarke trong cuốn sách 2001 a Space Odyssey, và một vài thập niên sau đã tạo nên một xu hướng thời trang được sử dụng bởi các ngôi sao nhạc pop như Kraftwerk.

Trong thập niên 70 sau đó, đã có rất nhiều phát minh trong lĩnh vực tổng hợp giọng nói như món đồ chơi Speak and Spell, chiếc ô tô biết nói Knight Rider-esque của những năm 80 (biết thông báo khi nhiên liệu sắp hết) và giọng nói nhân tạo được tạo ra dành cho nhà vật lý Stephen Hawking.

Tuy nhiên, sự khác biệt giữa những giọng nói thời đó và bây giờ là rất lớn. Những giọng nói nhân tạo thời đó nghe như robot bởi đó hoàn toàn là robot. Trở lại những năm 90, công suất của máy tính thời đó không đủ để tổng hợp giọng nói bằng cách thu âm tiếng nói của người, chia cắt thành từng phần nhỏ, xếp loại và tập hợp lại. Thay vào đó, bạn làm cho một chiếc máy tính nói được bằng cách lập trình một chuỗi các thông số âm thanh, giống như một chiếc máy synthesizer.

"Những chiếc máy đó thật sự rất đơn sơ khi đem so sánh với sự phức tạp của giọng nói con người" – theo Adam Wayment, phó kỹ sư trưởng của công ty Cepstral, một công ty chuyên về chuyển đổi văn bản thành giọng nói đã tạo ra hơn 50 giọng nói khác nhau. "Âm phát ra từ dây thanh âm, đi qua vòm họng, lọt vào khoang miệng, dội lại xung quanh lưỡi … tất cả đều là mô mềm". Do đó dù chiếc máy synthesizer có thể tạo ra những âm thanh rõ ràng, nhưng nó không thể giống với tiếng người. Kể cả một đứa trẻ cũng không ngây thơ đến mức nghĩ rằng mình có thể nói chuyện với món đồ chơi Speak and Spell của mình.

Cho tới những năm 2000, máy tính cuối cũng cũng đủ nhanh để lục tìm từ một cơ sở dữ liệu khổng lồ ra một tổ hợp những từ mới phù hợp, cho phép các công ty bắt đầu sản xuất ra những giọng nói nối âm nghe tự nhiên hơn. Cùng thời điểm đó, trí thông minh nhân tạo bắt đầu được phát triển tới một mức độ đủ để giúp cho máy tính đưa ra được những quyết định tinh vi liên quan đến ngôn ngữ. Khi bạn nói "wind" chẳng hạn, liệu bạn có phát âm như khi nói "the wind is blowing" hay như "wind" trong "wind the thread around the spool?". Một người trưởng thành sẽ nhận ra ngay sự khác biệt dựa vào bối cảnh. Nhưng một chiếc máy tính phải được chỉ dạy về bối cảnh đó.

Hứa hẹn về một chương trình chuyển đổi văn bản thành giọng nói đã có từ thời buổi sơ khai của những chiếc máy tính cá nhân – Apple thậm chí đã giới thiệu một phần mềm như vậy trong chiếc Mac đầu tiên. Nhưng chính sự phát triển mạnh mẽ của công nghệ di động và mạng Internet đã thực sự làm tăng nhu cầu về giọng nói điện tử.

Bạn có thể thấy tầm quan trọng của công nghệ chuyển đổi văn bản thành giọng nói bằng cách quan sát các kỹ sư làm việc. Trong một bức thư gửi cho các cổ đông vào tháng Mười Một năm ngoái, CEO của Microsoft Steve Ballmer đã nhấn mạnh tầm quan trọng của việc "diễn giải ngôn ngữ tự nhiên và học qua máy móc", hay những trí thông minh nhân tạo sử dụng lời nói.

Trong khi ngành công nghệ cao rất lạc quan về tương lai của giọng nói điện tử, ngạc nhiên thay lại có một số người không thích thú lắm với viễn cảnh này, đó chính là những diễn viên lồng tiếng. Đúng vậy, chính là những người cung cấp nguyên liệu thô cho ngành công nghiệp này. Lý do có lẽ chỉ là bởi họ không hiểu rõ về những tác động mà nó mang lại. Mặc dù vẫn có những người, như September Day hay Allison Dufty – một cựu diễn viên lồng tiếng của Nuance, người sẵn sàng công khai mọi thông tin về công việc của mình, nhưng những người đó rất hiếm. Nền tảng NDAs đã ngăn cách các diễn viên có thể gắn liền tên tuổi của mình với một thương hiệu nhất định. Những đại lý có mối quan hệ với các công ty công nghệ trong ngành thường úp úp mở mở nhằm giữ được lợi thế cạnh tranh của mình. Và trong bối cảnh thiếu thốn thông tin, sự hoang tưởng ngự trị.

"Trong ngành của mình, chúng tôi coi công nghệ chuyển đổi văn bản thành giọng nói (text to speech – TTS) là một mối đe dọa" – theo giám đốc marketing của trang web Voices.com, Stephanie Ciccarelli – "Họ nghĩ rằng nó sẽ thay thế những diễn viên lồng tiếng".

Một email được gửi tới một diễn viên lồng tiếng rất thành công, người từng làm việc cho các công ty như Wells Fargo, NPR, AT&T, đã nhận được một câu trả lời lịch sự nhưng cương quyết: "Điều duy nhất tôi có thể nói về ý kiến của các diễn viên lồng tiếng về TTS là họ nghĩ nó khá đáng ghét … Có lẽ một ngày nào đó nó sẽ đạt tầm của những bộ phim 3D hiện nay, nhưng giờ nó chẳng khác nào một trò đùa".

Trở lại với Nuance, Ward và Vazquez đang rất hào hứng với việc thử nghiệm công nghệ mới mà họ đang nghiên cứu. Ward giải thích rằng Nuance có thể kết hợp âm thanh tổng hợp và âm thanh nối, và làm cho chúng trở nên tự nhiên, và sớm thôi, chúng sẽ có thể giúp cho toàn bộ các giọng nói tổng hợp trở nên dễ nghe. Sức mạnh của máy tính đã đạt đến độ có thể tạo ra một giọng nói hoàn toàn tự nhiên, không có một chút robot nào.

"Nhưng giờ mọi thứ vẫn phụ thuộc vào giọng nói của người thật" – Ward nói. Kể cả một giọng nói tổng hợp cũng cần một khuôn mẫu để bắt chước.

Một ngày nọ, Ward và Vazquez đã thử nghiệm một sự kết hợp giữa một chiếc máy RSS với một chiếc máy phát nhạc thông minh: Chương trình có thể nhận ra bản tin mà nó đang đọc là vui hay buồn, và từ đó lựa chọn một bản nhạc thích hợp để làm nền, tạo cho người nghe một cảm giác chân thực. Họ bám chặt lấy ý tưởng về một ngày nào đó, chúng ta có thể được nghe bản tin bằng giọng của chính người viết, hoặc có thể về nhà và nói "là tôi đây" để điều chỉnh nhiệt độ theo ý mình, bằng cách sử dụng phần mềm nhận dạng giọng nói và trí thông minh nhân tạo.

"Đúng vậy. Anh có thể sử dụng phần mềm nhận dạng giọng nói để máy móc tự phun ra một loại hóa chất, và vợ anh sẽ không biết anh vừa hút thuốc" – Ward nói.

Bỏ qua những câu chuyện bông đùa qua một bên, viễn cảnh này không còn quá xa vời, nhất là khi xét đến sự tồn tại của công nghệ nhà thông minh như Nest, một phần mềm có thể ghi nhớ nhiệt độ mà bạn mong muốn, và điều chỉnh nhiệt độ trong nhà khi bạn đi và về.

Nhưng kể cả những giọng đọc hay cũng chưa chắc được chấp nhận (nhiều người thực sự rất ghét nghe giọng của chính mình). Dù vậy, vẫn còn những hứa hẹn về việc tạo những giọng nói tổng hợp tốt hơn, cho phép chúng ta có được sự giao tiếp hoàn thiện hơn với máy móc.

"Rất dễ dàng để hiểu được Siri, nhưng cái chúng ta vẫn cần là phần mềm này có thể truyền tải cảm xúc và tính cách như con người" – theo Benjamin Munson, một giáo sư về lĩnh vực ngôn ngữ tại Đại học Minnesota. Ở mức tối thiểu, ông nói, sẽ rất tuyệt nếu như những phần mềm như Siri hiểu được tâm trạng của người dùng và có phản hồi phù hợp, như cách một người có thể nhẹ nhàng đáp lại trước thái độ tức giận của khách hàng. Theo Munson, thứ được gọi là "ngôn ngữ không lời" mà chúng ta sử dụng đó rất khó để đưa vào công nghệ, nhưng ông nhấn mạnh rằng có nhiều nhà nghiên cứu đã bắt đầu tìm hiểu về vấn đề này.

"Khi tôi bắt đầu bước vào ngành này, phần lớn thị trường giọng nói tổng hợp là dành cho những hệ thống trả lời thư thoại tự động, và ý tưởng về việc tạo ra một giọng nói có thể truyền tải được cảm xúc và nhân cách không hề được quan tâm đến" – theo Matthew Aylett, giám đốc của công ty CereProc – "Sau cùng thì, bạn không hề muốn ngân hàng thông báo số dư tài khoản của mình với một giọng não nề trong khi mà bạn đang không có nhiều tiền".

Giờ đây, khi mà giọng nói tổng hợp được dùng để đọc blog, thậm chí toàn bộ cuốn sách Kindle, thông báo thời gian biểu, hay nhắc bạn về thăm bà, hoặc đơn giản là nhắc các mốc thời gian làm việc trong ngày tại công ty, thì có lẽ đã đến lúc thay đổi.

"Người máy R2D2 trong phim Star War luôn là robot yêu thích của tôi" – Aylett nói – "Nó vẫn nói giống như một robot, nhưng lại thể hiện được tính cách, cảm xúc và sự chế nhạo. Chúng tôi cũng đang cố gắng làm được như vậy".

Adam Wayment chia sẻ rằng, ông đã từng nói chuyện với một khách hàng khiếm thị, và anh ta nói rằng: "Anh có biết sử dụng một chiếc lò vi sóng khó khăn như thế nào không? Khi mà mỗi loại lại có cách bài trí riêng?". Điều này làm Wayment nảy ra ý tưởng về một thế giới toàn những chiếc lò vi sóng biết nói. Ông nói một cách nghiêm túc: "Tôi nghĩ rằng ngày đó đang tới, khi mà một thiết bị nhỏ cũng có thể nói được, nhưng chúng ta đang mạo hiểm lấp đầy cuộc sống của mình với những âm thanh. Chỉ những thiết bị biết nói thôi là không đủ, chúng phải nói cho chúng ta biết thứ mà chúng ta cần và thứ mà chúng ta muốn biết. Chúng phải có nội tâm".

Và nếu mọi thứ không được như vậy, chúng ta có thể nghĩ tới một ngành kinh doanh tiềm năng khác: Giai điệu của sự im lặng!

Công nghệ

-

Lợn có sức chiến đấu không mạnh lắm, vậy tại sao chúng vẫn chưa bị tuyệt chủng?

-

Làm thế nào để sống sót khi động đất xảy ra?

-

Hé lộ bí mật bên trong máy gắp thú bông, từ đó đúc kết kinh nghiệm giúp bạn tăng tỷ lệ thắng gấp nhiều lần

-

Khoảnh khắc hãi hùng khi khám phá Đại kim tự tháp 4.500 năm

-

Dùng tên lửa để... xây cầu, Trung Quốc khiến thế giới ngỡ ngàng với công trình "đi trên mây" độc đáo

-

Thời gian thực sự có thể quay ngược hay không?

Công nghệ mới

-

Robot bước đi giống rùa không cần mạch điện tử

-

Kính cửa sổ tích hợp pin năng lượng mặt trời

-

Sử dụng công nghệ in 3D tạo các kết cấu bằng thép

-

Xe lăn điều khiển bằng suy nghĩ thử nghiệm thành công ở khỉ

-

Chỉ cần đo hơi thở cũng phát hiện ra ung thư

-

Tìm ra cách thu được điện mặt trời ngay trong vũ trụ