Robot cũng phân biệt giới tính và chủng tộc

Các nhà nghiên cứu phát hiện nhiều chương trình máy tính và robot có hành vi phân biệt giới tính, chủng tộc như con người.

Các chuyên gia cảnh báo robot với trí thông minh nhân tạo đang dần thay con người quyết định nhiều việc, nhưng chúng cũng có những hành vi mang tính phân biệt giới tính và chủng tộc, Telegraph hôm 24/8 đưa tin.

Robot thay con người sàng lọc ứng viên dựa vào giới tính và chủng tộc. (Ảnh: Occupy Corporatism).

Nghiên cứu mới chỉ ra những chương trình robot được thiết kế để sơ loại ứng viên cho các trường học hoặc xét điều kiện làm bảo hiểm, vay ngân hàng có thể phân biệt đối xử với phụ nữ hoặc người da màu.

Được phát triển để lọc ứng viên cho một trường y ở Anh, chương trình máy tính này đã tự động loại bớt những ứng viên là phụ nữ, người da đen và người thuộc các dân tộc thiểu số.

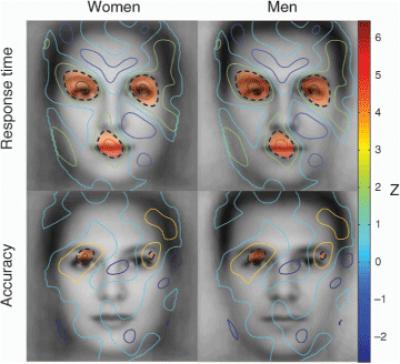

Các nhà nghiên cứu tại Đại học Boston đã chứng minh sự thiên vị trong các thuật toán của trí thông minh nhân tạo bằng cách huấn luyện một cỗ máy phân tích nội dung từ Google News. Khi được yêu cầu hoàn thành câu "Đàn ông là để làm lập trình viên máy tính, phụ nữ là để…", thì cỗ máy trả lời "làm nội trợ".

Một chương trình máy tính khác của Mỹ được yêu cầu kiểm tra những bức ảnh trên mạng xã hội. Đến tấm hình một người đàn ông đứng trong bếp, máy vẫn nhận diện đó là phụ nữ.

Giáo sư Noel Sharkey cảnh báo về tình trạng phân biệt giới tính, chủng tộc ở robot. (Ảnh: PA).

Theo giáo sư Noel Sharkey, giám đốc tại tổ chức Foundation for Responsible Robotics, các thuật toán Deep Learning chi phối phần mềm của trí thông minh nhân tạo chưa có sự công bằng bởi phần lớn kỹ sư công nghệ thông tin hiện nay là nam giới. Nữ giới hiện chiếm xấp xỉ 9% nhân lực ngành kỹ sư ở Anh và chỉ chiếm 20% tổng số người theo học chương trình Vật lý nâng cao A-Level.

Vấn đề chủ yếu do lỗi dữ liệu sai lệch mà các nền tảng robot đang sử dụng, theo Maxine Mackintosh, chuyên gia hàng đầu về dữ liệu y tế.

"Các dữ liệu này là chiếc gương của xã hội – chúng phản ánh sự thiên vị và bất bình đẳng trong cộng đồng", bà nói với BBC. "Nếu muốn thay đổi điều đó, bạn không thể chỉ dùng thông tin cũ".

Theo điều tra của tổ chức ProPublica năm ngoái, chương trình COMPAS mà một toà án Mỹ sử dụng để đánh giá rủi ro đã nhìn nhận tù nhân da đen một cách tiêu cực. Nó có xu hướng đánh giá nhầm là tù nhân da đen dễ tái phạm hơn so với tù nhân da trắng.

Công nghệ

-

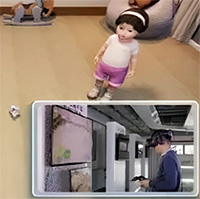

Nhà khoa học Trung Quốc tạo ra "đứa trẻ" AI đầu tiên trên thế giới

-

Lưu ý khi sử dụng lò vi sóng bạn nên biết

-

Bạn có biết: Máu trong cơ thể phi hành gia chảy khác hẳn khi trong không gian

-

Cách để "thức cả đêm" mà không mệt mỏi theo kinh nghiệm của NASA

-

Humvee trở thành huyền thoại xe quân sự như thế nào?

-

3,5 triệu USD là giá tiền cho loại thuốc đắt nhất thế giới

AI - Trí tuệ nhân tạo

-

Trí tuệ nhân tạo vượt kiến thức cờ hàng trăm năm trong 4 tiếng

-

Làm sao chúng ta biết AI sẽ vâng lời? Có lẽ là nhìn cách chúng tranh luận với chính mình

-

Phần mềm AI dịch tiếng khóc của trẻ sơ sinh

-

Phi công AI đánh bại con người trong trận không chiến

-

Các nhân vật trong truyện tranh Conan sẽ có dung nhan thực tế như thế nào ngoài đời thật?

-

Facebook đang dạy robot cách biểu hiện giống như con người