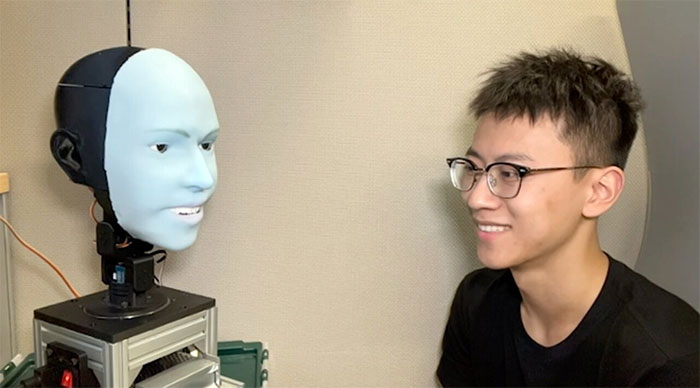

Robot AI tiên đoán và cười cùng lúc với người đối diện

Robot Emo có thể dự đoán nụ cười khoảng 840 mili giây trước khi người đối diện cười, sau đó cười cùng lúc.

Robot Emo có thể dự đoán biểu cảm và cười cùng lúc với người đối diện. (Video: New Scientist)

Con người đang dần quen với những robot có khả năng giao tiếp thành thạo bằng lời nói, một phần nhờ vào sự tiến bộ trong các mô hình ngôn ngữ lớn như ChatGPT, nhưng các kỹ năng giao tiếp phi ngôn ngữ của chúng, đặc biệt là nét mặt, vẫn còn kém xa. Việc thiết kế một robot không chỉ thể hiện được nhiều biểu cảm trên khuôn mặt mà còn biết thể hiện đúng lúc vô cùng khó.

Phòng thí nghiệm Máy móc Sáng tạo tại Trường Kỹ thuật thuộc Đại học Columbia, Mỹ, đã nghiên cứu vấn đề này suốt hơn 5 năm. Trong nghiên cứu mới trên tạp chí Science Robotics, nhóm chuyên gia tại đây đã giới thiệu Emo, một robot AI có thể tiên đoán các biểu cảm trên khuôn mặt con người và thực hiện cùng lúc với người đó, TechXplore hôm 27/3 đưa tin. Nó dự đoán nụ cười khoảng 840 mili giây trước khi người đối diện cười, sau đó cười cùng lúc.

Robot Emo là một bước tiến đáng kể trong giao tiếp phi ngôn ngữ giữa con người và robot. (Ảnh: popsci)

Ngoài ra, Emo có thể thể hiện 6 cảm xúc cơ bản như: Tức giận, ghê tởm, sợ hãi, vui vẻ, buồn bã và ngạc nhiên, cũng như một loạt các phản ứng nhiều sắc thái hơn. Điều đó là nhờ vào cơ nhân tạo làm từ dây cáp và động cơ. Emo thể hiện cảm xúc bằng cách kéo các cơ nhân tạo vào các điểm cụ thể trên khuôn mặt.

Nhóm nghiên cứu cũng đã sử dụng phần mền Trí tuệ nhân tạo (AI) để dự đoán nét mặt con người và tạo ra nét mặt robot tương ứng: “Emo giải quyết những vấn đề bằng cách sử dụng 26 động cơ, làn da mềm mại và đôi mắt được gắn camera. Vì vậy, nó có thể thực hiện các giao tiếp không lời, như giao tiếp bằng mắt và nét mặt. Emo được trang bị một số mô hình AI bao gồm phát hiện khuôn mặt người, điều khiển bộ truyền động khuôn mặt để bắt chước nét mặt và thậm chí dự đoán nét mặt con người. Điều này cho phép Emo tương tác theo cách cảm thấy kịp thời và chân thực”.

Nhóm nghiên cứu phát triển hai mô hình AI. Mô hình thứ nhất dự đoán biểu cảm khuôn mặt người bằng cách phân tích những thay đổi tinh vi trên khuôn mặt đối diện, mô hình thứ hai tạo ra các lệnh vận động bằng cách sử dụng những biểu cảm tương ứng.

Để đào tạo robot cách biểu cảm, nhóm nghiên cứu đặt Emo trước camera và để nó thực hiện những cử động ngẫu nhiên. Sau vài giờ, robot học được mối quan hệ giữa biểu cảm khuôn mặt với các lệnh vận động - tương tự cách con người luyện tập biểu cảm khi nhìn vào gương. Nhóm nghiên cứu gọi đây là "tự làm mẫu" - tương tự với khả năng con người tưởng tượng ra mình trông như thế nào khi thực hiện một số biểu cảm nhất định.

Giờ đây, robot có thể tích hợp biểu cảm khuôn mặt để phản hồi.

Tiếp theo, nhóm nghiên cứu phát những video về biểu cảm khuôn mặt người để Emo quan sát từng khung hình. Sau quá trình đào tạo kéo dài nhiều giờ, Emo có thể tiên đoán biểu cảm bằng cách quan sát những thay đổi tinh vi của khuôn mặt khi một người bắt đầu có ý định mỉm cười.

"Tôi cho rằng dự đoán chính xác biểu cảm khuôn mặt người là một cuộc cách mạng trong lĩnh vực tương tác người - robot. Trước đây, robot không được thiết kế để xem xét biểu cảm của con người trong quá trình tương tác. Giờ đây, robot có thể tích hợp biểu cảm khuôn mặt để phản hồi", Yuhang Hu, nghiên cứu sinh tiến sĩ tại Phòng thí nghiệm Máy móc Sáng tạo, thành viên nhóm nghiên cứu, cho biết.

"Việc robot thực hiện những biểu cảm cùng lúc với con người theo thời gian thực không chỉ giúp nâng cao chất lượng tương tác mà cũng giúp xây dựng niềm tin giữa con người và robot. Trong tương lai, khi tương tác với robot, nó sẽ quan sát và diễn giải biểu cảm gương mặt của bạn, giống như một con người thực sự", Hu bổ sung.

Nhóm nghiên cứu dự định tích hợp giao tiếp bằng lời nói vào Emo, Yuhang Hu cho biết thêm: “Bước tiếp theo của chúng tôi liên quan đến việc tích hợp khả năng giao tiếp bằng lời nói. Điều này sẽ cho phép Emo tham gia vào các cuộc trò chuyện phức tạp và tự nhiên hơn”.

Công nghệ

-

Dùng tên lửa để... xây cầu, Trung Quốc khiến thế giới ngỡ ngàng với công trình "đi trên mây" độc đáo

-

Khoảnh khắc hãi hùng khi khám phá Đại kim tự tháp 4.500 năm

-

Rắn biển Belcher - Loài rắn độc nhất thế giới

-

Làm thế nào để sống sót khi động đất xảy ra?

-

Lợn có sức chiến đấu không mạnh lắm, vậy tại sao chúng vẫn chưa bị tuyệt chủng?

-

Thời gian thực sự có thể quay ngược hay không?

AI - Trí tuệ nhân tạo

-

AI điều khiển máy bay phản lực trong 17 tiếng

-

Trung Quốc phát triển AI mới dự báo bão, El Nino

-

Robot đầu tiên trên thế giới được cấp quyền công dân

-

Trí tuệ nhân tạo giúp con người làm việc năng suất như thế nào?

-

AI có thể đoán được tính cách chỉ qua ảnh selfie

-

Công nghệ AI giúp đo mức mỡ màng ngoài tim